迷惑なbotを制限・拒否する方法 Blackhole for Bad Botsの使い方

当ブログにも、多くのbotやクローラーが日々訪れます。その中には、短期間で数百、数千もアクセスしてくる迷惑なものも存在します。

検索エンジンのボットやクローラーには来てもらいたいですが、訳のわからないものはあまり来てほしくありません。

大量にアクセスしてくるbotやクローラーの多くは、SEO関連のものです。しかし、自分が利用していないツールであれば、あえてクロールさせる必要は無いです。また、大量アクセスはサーバーにも負荷を与えるので、アクセスを制限・拒否する方が良いです。

そこで、便利なプラグインが「Blackhole for Bad Bots」です。手動でrobots.txtに一つ一つ書き込むのも可能ですが、こちらのプラグインを使えば、一つ書き込むだけであらゆる迷惑botのアクセスを拒否できます。一応、手動でもできるように、迷惑と言われることが多いbotの一覧も紹介しております。

前にも類似のプラグインを紹介していますので、こちらもどうぞ。

Blackhole for Bad Botsの使い方

インストールし、有効化します。

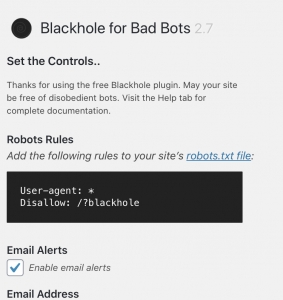

そして、説明の通りに、robots.txtに、

User-agent: * Disallow: /?blackhole と書き込みます。robots.txtを編集する方法についてはこちらの記事↓を参照。

これで基本の設定は完了です。

続いては、詳細な設定です。アクセスを許可したいbotやクローラーの名前、IPアドレスをホワイトリストに追加します。

自分が使っているSEO関連のツールや、バックアップのサービスなどのbotやクローラーが、アクセスできなくならないように注意しましょう。

アクセスをブロックされた際に表示されるメッセージはそのままでも良いですし、適宜変更を加えてもOKです。

迷惑なbot

MJ12bot、SiteExplorer、Robot、GrapeshotCrawler、OppO、SemrushBot、proximic、spider、TurnitinBot、MegaIndex、bidswitchbot、SMTBot、ltx71、integralads、jet-bot、trendictionbot、Mappyなどが挙げられます。他にもあれば追加しますので、コメントして下さい。

先程も書いた通り、多くはSEO関係のものです。海外のものが多く、明らかに利用することはないというものもあります。手動で特定のユーザーエージェントのみをアクセス拒否することで、自分が利用しているツールが使えなくなる、という可能性は低くなります。

まとめ

botやクローラーは、検索エンジンへの登録や、様々なツールを使う上で重要な役割を果たします。

しかし、一部の大量アクセスを行うものは、サーバーに負荷をかけ、503エラーの原因にもなりますので、アクセスを拒否するのも検討しましょう。

サーバーの容量が大きいのであれば気にすることはないでしょうが、大量アクセスを想定していない個人のブログであれば、今回のプラグインなどを使って対策を講じる必要があるでしょう。

普段からアクセス解析を用いて、大量アクセスや不審なアクセスが無いかを確認するようにしましょう。

ディスカッション

コメント一覧

まだ、コメントがありません

コメントは管理者の承認後公開されます。公開を希望されない方は、その旨をコメントに添えて下さい。スパム対策のため、日本語が含まれない投稿は無視されますのでご注意ください。